Guillaume Aupy Pallez, jeune chargé de recherche engagé dans la communauté du HPC

Date:

Mis à jour le 08/04/2021

De sa courte et brillante trajectoire, déjà marquée par de nombreuses publications, Guillaume Aupy Pallez retient deux temps forts : son succès fin 2016 au concours de chargé de recherche d’Inria, « un statut quasi unique au monde, qui est garant de nos libertés académiques et qu’il faut protéger » et sa participation en 2017 à l’élaboration du programme scientifique de Supercomputing, la plus grande conférence mondiale en HPC.

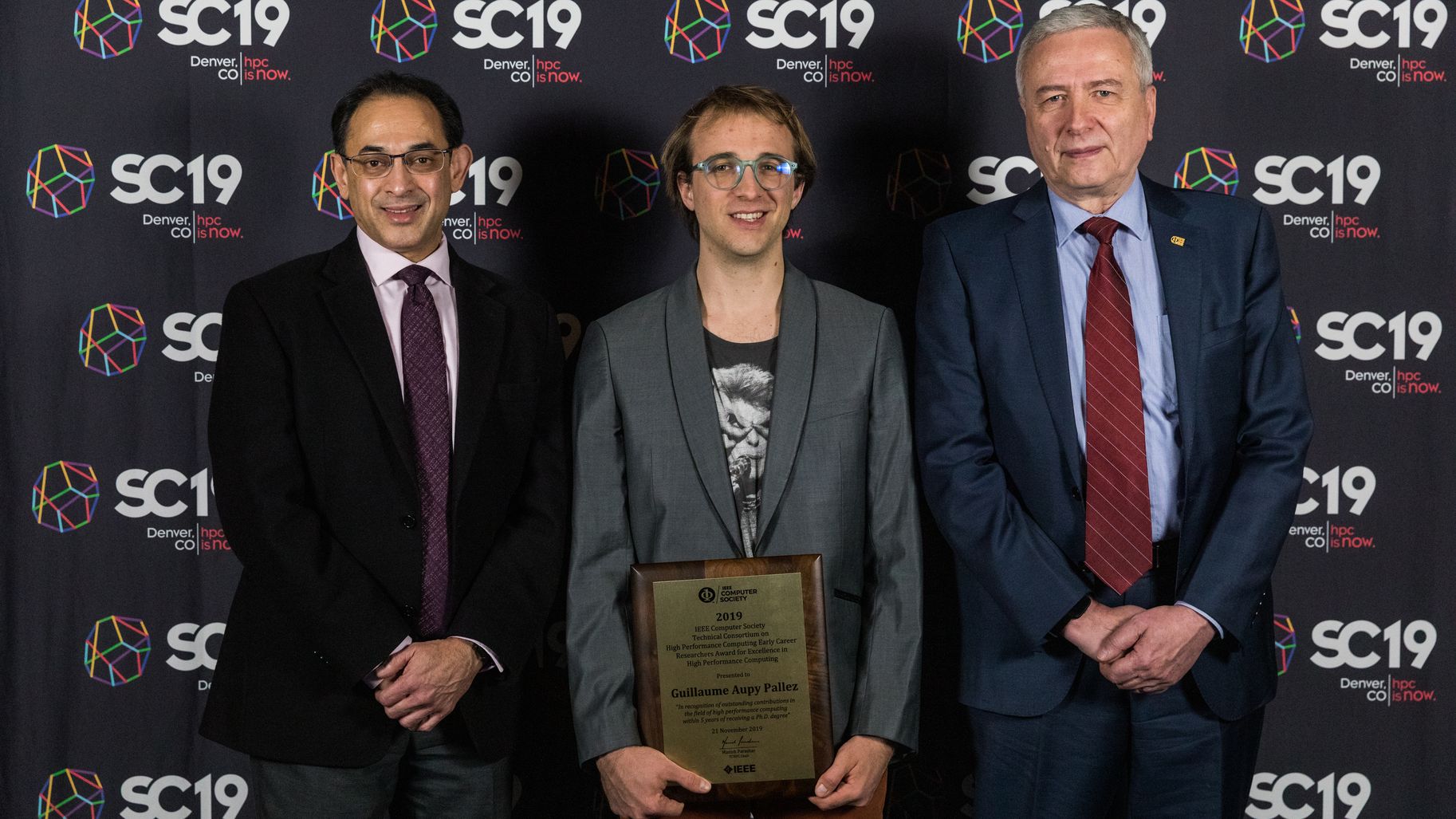

En revanche, le jeune chercheur estime ne pas avoir encore le recul nécessaire sur le prix IEEE TCHPC qu’il vient de recevoir à Denver (États-Unis). Même s’il est évidemment très heureux de cette distinction.

« Comprendre les difficultés pratiques de calcul »

Recevoir un prix qui bénéficie d’une telle visibilité est très rassurant pour moi, car je remets constamment en question les thématiques que je choisis. Cela dit, je trouve le principe du prix individuel étrange : par essence, la recherche est collective et collaborative.

Guillaume Aupy Pallez appartient en effet à TADaaM, une équipe-projet Inria commune avec le LaBRI (Laboratoire bordelais de recherche en informatique), l’université de Bordeaux et Bordeaux INP. Il a effectué un postdoc à l’université de Vanderbilt à Nashville (États-Unis), avec laquelle il renoue depuis 2018 sur un nouveau sujet. Il entretient des liens avec le laboratoire national d’Argonne (États-Unis) et l’université de Madrid. « J’ai un profil plutôt théorique et j’aime discuter avec des équipes plus axées sur des applications pour comprendre leurs difficultés pratiques de calcul. Ensemble, nous étudions les verrous scientifiques qui servent ensuite à nourrir et inspirer mon travail. »

Le jeune chercheur s’est spécialisé sur l’ordonnancement, un enjeu central du HPC. Pour le comprendre, il faut imaginer un supercalculateur comme une usine dont les machines battent des records de productivité. Le problème n’est plus de les faire tourner mais de les approvisionner assez vite en matières premières, puis d’évacuer rapidement leurs produits finis.

L’ordonnancement, c’est exactement cela : définir un ordre optimal d’exécution des tâches sur plusieurs nœuds de calcul parallèles, avec cette difficulté supplémentaire qu’il faut gérer d’énormes volumes de données en entrée et de résultats en sortie. Or, pour des raisons de coût, ces données et ces résultats sont stockés sur des mémoires de taille et de rapidité variables, plus ou moins éloignées des nœuds de calcul. C’est un double goulet d’étranglement qui allonge beaucoup les temps de traitement.

L’une des avancées de Guillaume Aupy Pallez a été d’étudier le comportement d’applications HPC pour déterminer si certains enchaînements de tâches se répétaient régulièrement. Par exemple, l’application calcule pendant neuf minutes, génère 30 Go de données, les transmet à une mémoire, repart pour neuf minutes de calcul, etc.

On peut ainsi bâtir un ordonnancement statique sur certains nœuds et lui associer sur d’autres nœuds un ordonnancement dynamique d’applications au comportement moins prévisible.

Ces travaux ont permis au jeune chercheur d’obtenir en 2017 une bourse ANR (Agence nationale de la recherche) pour quatre ans.

L’ordonnancement est également critique pour mettre au point des modèles HPC complexes (exemple : fonte des calottes glaciaires des pôles en fonction du climat), ou des algorithmes d’apprentissage statistique en intelligence artificielle. Ces modèles ne sont pas fidèles à la réalité dès leur première version : il faut les ajuster peu à peu et pour cela, les revisiter en "marche arrière", en remontant des derniers calculs vers les premiers.

Ce travail, appelé "différentiation automatique", impose à chaque étape d’accéder aux résultats des calculs de l’étape précédente. Mais il est impossible de tous les archiver en raison du coût des capacités mémoire. La solution étudiée par Guillaume Aupy Pallez ? « On conserve uniquement certaines données critiques, en choisissant d’en recalculer d’autres. Toute la difficulté étant de définir quelles données doivent être stockées. »

Depuis un an, l’université américaine de Vanderbilt a repris contact avec son ancien postdoctorant pour un nouveau sujet : l’ordonnancement d’applications de cartographie du cerveau pour les neurosciences. Ces applications ont un comportement dit "stochastique" : leur temps d’exécution est imprévisible, car lié au contenu des images. Par précaution, Vanderbilt réserve donc des plages horaires de longue durée sur le supercalculateur auquel sont confiés ces calculs ; en contrepartie, elle doit attendre plusieurs jours pour qu’un créneau d’accès se libère.

Guillaume Aupy Pallez et ses collaborateurs utilisent de nouveau la modélisation pour représenter ces temps d’exécution en les assortissant de probabilités. Exemple : l’application a 25 % de chances de s’exécuter en 15 minutes, 25 % de chances en 30 minutes, etc. Vanderbilt peut demander des plages horaires plus courtes et récupère ses résultats plus vite.

Ces applications stochastiques ne sont pas optimisées pour le HPC. Mais vu leur poids, on les exécute de plus en plus sur des supercalculateurs. Les questions scientifiques qui en découlent me passionnent et occuperont sans doute mes prochaines années.

* High Performance Computing (calcul haute performance)

** IEEE Computer Society Technical Consortium on High Performance Computing