Le problème du videur : la crédibilité des explications de l’IA en question

De plus en plus d’algorithmes dits d’IA (intelligence artificielle), sont déployés dans les entreprises ou institutions pour fournir des décisions aux utilisateurs. L'impact de ces algorithmes sur la vie de leurs utilisateurs varie fortement : il est relativement limité pour les algorithmes de recommandation (qui trient l'information disponible sur une plate-forme pour choisir un ensemble restreint d'objets à consommer par l'internaute), mais bien plus important pour les algorithmes d’allocation de crédit, et plus encore pour ceux qui déterminent les priorités d’hospitalisations.

Face à l'obscurité des décisions prises, et au fait que les paramètres de ces algorithmes ne sont généralement pas rendus publics, de plus en plus de personnes s'interrogent sur la justesse, l’absence de biais, ou les raisons précises de telle ou telle décision. Certaines plates-formes donnent des explications, qui restent laconiques (par exemple, YouTube : "Le public de X regarde aussi cette chaîne", ou Facebook : "Why am I seing this ad?"). L'explicabilité des systèmes d'intelligence artificielle sera-t-elle alors la pierre angulaire nécessaire à la confiance des utilisateurs confrontés aux décisions des algorithmes d'IA ? Probablement pas.

En effet, nous montrons dans cet article qu’il est très facile pour une entité malveillante de falsifier les explications de son algorithme décisionnel.

L’analogie du videur

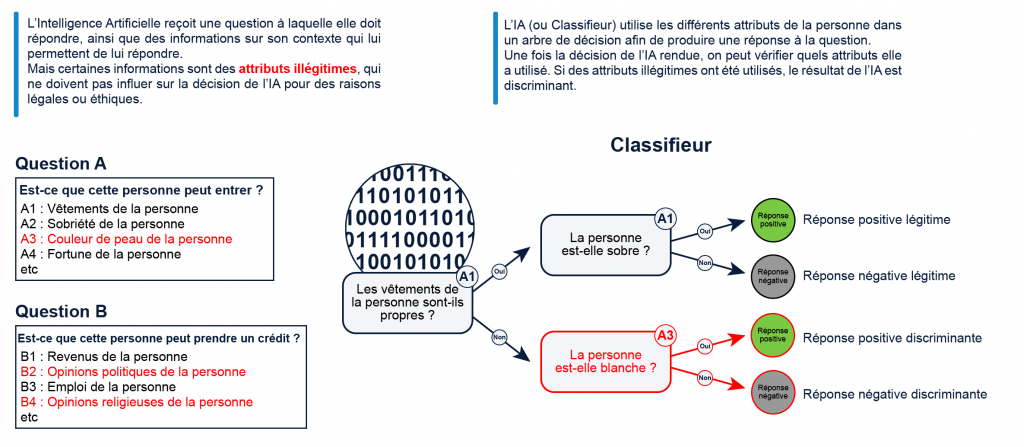

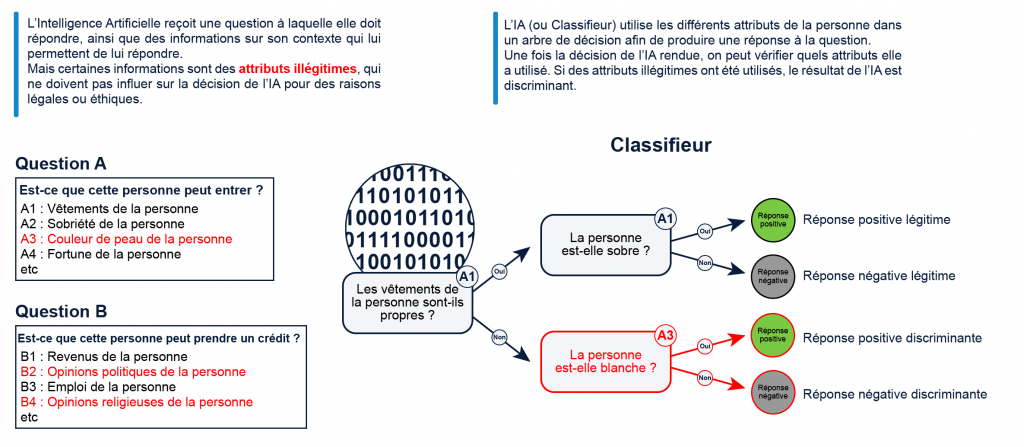

Pour l’illustrer, nous partons d’une analogie entre le videur d’une boîte de nuit (qui décide si un client qui se présente peut entrer ou pas) et un classifieur (un algorithme d'IA qui attribue un label à chaque requête). D'un point de vue abstrait, le rôle du videur est d’abord d’observer chaque candidat à l’entrée en boîte de nuit, et ensuite de décider si le candidat peut entrer. En d’autres termes, il attribue un label ("peut entrer"/"ne peut pas entrer") à chaque requête (chaque client qui se présente) : c’est un classifieur binaire.

Obligeons maintenant notre videur à donner une explication pour chaque décision : le videur devient un classifieur explicable. L'idée peut à première vue paraître séduisante : si le videur doit s'expliquer, il lui sera plus difficile de baser sa décision d'admission sur de mauvais critères. La perspective pour le videur de devoir avouer qu’il sélectionne les candidats à l’entrée sur - par exemple - leur couleur de peau (alors que c’est interdit par la loi), nous apporterait une garantie de qualité sur le processus de sélection. C’est en tout cas le raisonnement qui a pu pousser la Commission européenne et différents organismes à envisager l’explicabilité des algorithmes comme une solution pour l’acceptation des techniques d'IA par le public.

Seulement voilà , le videur peut mentir. En effet, il peut librement refuser l’entrée à un individu pour des raisons discriminatoires (par exemple sa couleur de peau), tout en invoquant d’autres raisons dans son explication (par exemple sa tenue). Et puisqu'on ne peut pas "lire" dans la tête d’un videur, ce mensonge n’est pas détectable pour un utilisateur isolé. En résumé, si l’on doute de l’honnêteté du videur, ses explications ne changeront probablement rien au doute sur sa conduite.

Qu'en est-il de ce raisonnement dans le monde numérique ? L'exemple ci- dessus souligne que le nœud du problème réside dans la capacité du videur à inventer des explications. Pour étudier cette question dans le monde des classifieurs, nous devons formaliser quelques notions.

Un modèle simple d’explication des décisions

Classifieur : Nous considérons un classifieur parmi l’ensemble des classifieurs binaires, répondant "oui" ou "non" à des requêtes. Ces requêtes proviennent de l’espace d’attributs, qui ainsi décrit l’ensemble des attributs considérés par le classifieur pour exécuter son action. Nous considérons que cet ensemble contient deux types d’attributs : les attributs légitimes et les attributs discriminatoires. Les attributs légitimes sont ceux sur lesquels notre classifieur a le droit de baser sa décision et ses explications. Les attributs illégitimes — ici définis comme discriminatoires — sont les attributs qu'il n’a pas le droit d'utiliser. À titre d'exemple, si le classifieur implémente un videur, l’ensemble d’attributs légitimes encodera des informations du candidat à l’entrée sur le soin de sa tenue, ou sa possible ivresse. L'ensemble d’attributs discriminatoires encodera par contre des informations sur la couleur de peau ou le genre du candidat.

Discrimination : Cette partition des attributs d'entrée engendre une partition des classifieurs. On distinguera ainsi l’ensemble des classifieurs légitimes, c’est-à -dire n'utilisant que des attributs légitimes pour produire une décision, et l’ensemble complémentaire contenant les autres classifieurs qui utilisent au moins un attribut discriminatoire. Nous pouvons maintenant formuler la question qui nous anime : "face à un classifieur, peut-on déterminer s'il est discriminatoire ou pas, en se basant sur des explications accompagnant la décision ?"

Interaction : Il nous reste maintenant à préciser l’interaction que nous pouvons avoir avec le classifieur. Comme il s’agit d’un classifieur mis à disposition par une plate-forme, nous sommes devant une interaction en boîte noire : nous ne pouvons que lui soumettre des entrées, puis collecter chaque décision (sans aucune idée, donc, sur le traitement effectué sur ces entrées).

Explication : Enfin, ajoutons une explication : supposons que le classifieur soit explicable (ce qui n’est parfois pas une mince affaire, voire impossible nativement dans le cas des réseaux de neurones) et qu’il soit en mesure de produire pour chaque requête une explication de la décision. Supposons de plus que celle-ci soit si complète qu’elle permette de tout révéler, et en particulier de révéler si le classifieur s’est appuyé sur un attribut discriminatoire : une seule explication obtenue d’un classifieur discriminatoire révèle qu'il est discriminatoire.

De plus en plus d’algorithmes dits d’IA (intelligence artificielle), sont déployés dans les entreprises ou institutions pour fournir des décisions aux utilisateurs. L'impact de ces algorithmes sur la vie de leurs utilisateurs varie fortement : il est relativement limité pour les algorithmes de recommandation (qui trient l'information disponible sur une plate-forme pour choisir un ensemble restreint d'objets à consommer par l'internaute), mais bien plus important pour les algorithmes d’allocation de crédit, et plus encore pour ceux qui déterminent les priorités d’hospitalisations.

Face à l'obscurité des décisions prises, et au fait que les paramètres de ces algorithmes ne sont généralement pas rendus publics, de plus en plus de personnes s'interrogent sur la justesse, l’absence de biais, ou les raisons précises de telle ou telle décision. Certaines plates-formes donnent des explications, qui restent laconiques (par exemple, YouTube : "Le public de X regarde aussi cette chaîne", ou Facebook : "Why am I seing this ad?"). L'explicabilité des systèmes d'intelligence artificielle sera-t-elle alors la pierre angulaire nécessaire à la confiance des utilisateurs confrontés aux décisions des algorithmes d'IA ? Probablement pas.

En effet, nous montrons dans cet article qu’il est très facile pour une entité malveillante de falsifier les explications de son algorithme décisionnel.

L’analogie du videur

Pour l’illustrer, nous partons d’une analogie entre le videur d’une boîte de nuit (qui décide si un client qui se présente peut entrer ou pas) et un classifieur (un algorithme d'IA qui attribue un label à chaque requête). D'un point de vue abstrait, le rôle du videur est d’abord d’observer chaque candidat à l’entrée en boîte de nuit, et ensuite de décider si le candidat peut entrer. En d’autres termes, il attribue un label ("peut entrer"/"ne peut pas entrer") à chaque requête (chaque client qui se présente) : c’est un classifieur binaire.

Obligeons maintenant notre videur à donner une explication pour chaque décision : le videur devient un classifieur explicable. L'idée peut à première vue paraître séduisante : si le videur doit s'expliquer, il lui sera plus difficile de baser sa décision d'admission sur de mauvais critères. La perspective pour le videur de devoir avouer qu’il sélectionne les candidats à l’entrée sur - par exemple - leur couleur de peau (alors que c’est interdit par la loi), nous apporterait une garantie de qualité sur le processus de sélection. C’est en tout cas le raisonnement qui a pu pousser la Commission européenne et différents organismes à envisager l’explicabilité des algorithmes comme une solution pour l’acceptation des techniques d'IA par le public.

Seulement voilà , le videur peut mentir. En effet, il peut librement refuser l’entrée à un individu pour des raisons discriminatoires (par exemple sa couleur de peau), tout en invoquant d’autres raisons dans son explication (par exemple sa tenue). Et puisqu'on ne peut pas "lire" dans la tête d’un videur, ce mensonge n’est pas détectable pour un utilisateur isolé. En résumé, si l’on doute de l’honnêteté du videur, ses explications ne changeront probablement rien au doute sur sa conduite.

Qu'en est-il de ce raisonnement dans le monde numérique ? L'exemple ci- dessus souligne que le nœud du problème réside dans la capacité du videur à inventer des explications. Pour étudier cette question dans le monde des classifieurs, nous devons formaliser quelques notions.

Un modèle simple d’explication des décisions

Classifieur : Nous considérons un classifieur parmi l’ensemble des classifieurs binaires, répondant "oui" ou "non" à des requêtes. Ces requêtes proviennent de l’espace d’attributs, qui ainsi décrit l’ensemble des attributs considérés par le classifieur pour exécuter son action. Nous considérons que cet ensemble contient deux types d’attributs : les attributs légitimes et les attributs discriminatoires. Les attributs légitimes sont ceux sur lesquels notre classifieur a le droit de baser sa décision et ses explications. Les attributs illégitimes — ici définis comme discriminatoires — sont les attributs qu'il n’a pas le droit d'utiliser. À titre d'exemple, si le classifieur implémente un videur, l’ensemble d’attributs légitimes encodera des informations du candidat à l’entrée sur le soin de sa tenue, ou sa possible ivresse. L'ensemble d’attributs discriminatoires encodera par contre des informations sur la couleur de peau ou le genre du candidat.

Discrimination : Cette partition des attributs d'entrée engendre une partition des classifieurs. On distinguera ainsi l’ensemble des classifieurs légitimes, c’est-à -dire n'utilisant que des attributs légitimes pour produire une décision, et l’ensemble complémentaire contenant les autres classifieurs qui utilisent au moins un attribut discriminatoire. Nous pouvons maintenant formuler la question qui nous anime : "face à un classifieur, peut-on déterminer s'il est discriminatoire ou pas, en se basant sur des explications accompagnant la décision ?"

Interaction : Il nous reste maintenant à préciser l’interaction que nous pouvons avoir avec le classifieur. Comme il s’agit d’un classifieur mis à disposition par une plate-forme, nous sommes devant une interaction en boîte noire : nous ne pouvons que lui soumettre des entrées, puis collecter chaque décision (sans aucune idée, donc, sur le traitement effectué sur ces entrées).

Explication : Enfin, ajoutons une explication : supposons que le classifieur soit explicable (ce qui n’est parfois pas une mince affaire, voire impossible nativement dans le cas des réseaux de neurones) et qu’il soit en mesure de produire pour chaque requête une explication de la décision. Supposons de plus que celle-ci soit si complète qu’elle permette de tout révéler, et en particulier de révéler si le classifieur s’est appuyé sur un attribut discriminatoire : une seule explication obtenue d’un classifieur discriminatoire révèle qu'il est discriminatoire.